library(ggplot2)

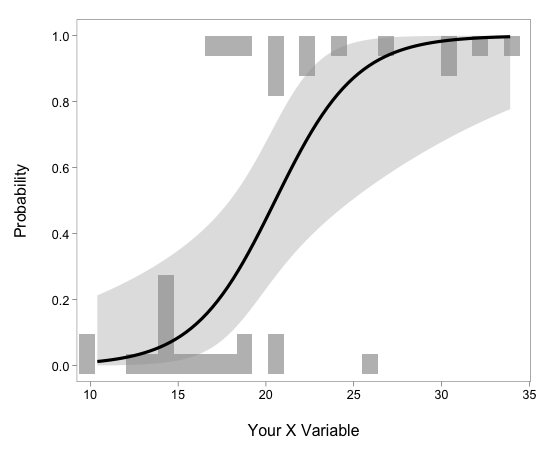

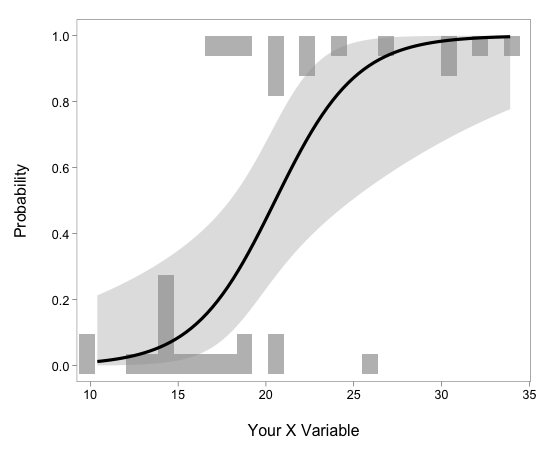

を応用したロジスティック回帰の図示の例.

なるほど,

いろいろやりようがあるもんだな

……

library(lme4)

の lmer() やめましょう

library(MCMCglmm)

の MCMCglmm()

のほうがマシです (使いましょう)

MCMCglmm()

をどう使えばよいのか,

というメイルが毎日のようにきて,

その対処におわれぎみ.

自業自得ではあるが

……

まあ

「lmer() でわけのわからない結果ばかりが得られます」

に対処するよりはマシだと思うことにしよう.

library(MCMCglmm)

を使いこなすのは,

BUGS 系さんぷらーを使いこなすのと同程度の理解が必要であり,

しかも BUGS な連中よりは「できること」が限定されている

MCMCglmm()

のような「限定されたことしかできないもの」のほうが好まれる

傾向があるような気がする.

library(foreach)

と library(doMC)

(ゐんどーづだと library(doSMP) か?)

の組みあわせなのかなあ?

……

dichika さんの BOD

2011-02-09

エントリー参照.

library(randomForest)

の例題を自分の ThinkPad X201s でやってみたところ,

並列化しない場合は 8.2 秒,

ふたつに分割すると 22.3 秒

と遅くなっている.

library(randomForest)

が (昨年 2 月と比較して) 何か猛烈なるシングルスレッド最適化をしたのか,

はたまた逆に並列化のおーばーへっどがたいへんになったのか?

library(doMC) による仕事分割は

2 → 4 ではまあ妥当に変化しているように見える

……

仕事分割数を二倍にすると処理時間はだいたい半分になったので.

しかし分割しない場合にまだ負けており,

しかも分割しない場合は正しくひとつのコアしか働いていないように見える.

なぜだ?

google-chrome

とかメモリをどか食いしてるソフトウェアが起動しているときに,

library(doMC) な並列化をやらせると,

けっこう paging が発生している.

google-chrome

とかを終了してメモリの空き地を増やしてからやってみると

……

MCMCglmm()

こんさるメイルで少し苦しんでみる.

MCMCglmm()

の出力には以下のような table がふくまれているわけだが,

post.mean l-95% CI u-95% CI eff.samp pMCMC

(Intercept) -0.361 -0.921 0.190 2862 0.1933

log(stem_Do) 0.685 0.175 1.171 2645 0.0073

sexm -0.548 -1.251 0.265 3000 0.1600

log(stem_Do):sexm -1.016 -1.897 -0.230 3000 0.0160

この pMCMC

とは何だろうか?

MCMCglmm()

の作者 Jarrod Hadfield が r-sig-mixed-models

なるメイリングリストで説明するところ

(2011-08-24)

によると

(document には書いてない!),

pMCMC is the two times the smaller of the two quantities: MCMC estimates of i) the probability that a<0 or ii) the probability that a>0, where a is the parameter value. Its not a p-value as such, and better ways of obtaining Bayesian p-values exist.だってさ. ためしに計算してみたら,

> sum(fit.mcmc$Sol[,1] > 0) * 2 / nrow(fit.mcmc$Sol) [1] 0.19333 > sum(fit.mcmc$Sol[,1] < 0) * 2 / nrow(fit.mcmc$Sol) [1] 1.8067たしかに

0.1933

になってますなぁ

……

HPDinterval finds the closest points (c and d) for which Fa(d)-Fa(c) = 0.95 (If prob=0.95 in HPDinterval) and Fa is the empirical cumulative distribution of a.とのこと.

https://stat.ethz.ch/mailma だけでも)

こんなに

たくさん!